En collaboration avec les Ambassadeur·ices des Transitions

Par Hugo Retail & Ulysse Iparraguirre

L’année dernière, entre travail et cours, je ne prenais pas toujours le temps de lire les textes des TD. Je me suis mis, assez souvent, à demander des résumés à ChatGPT. Toi aussi, comme beaucoup d’étudiant·es tu te sers peut-être de l’IA pour t’aider dans tes études. Bien utilisé, c’est un outil efficace qui, depuis 2022, s’impose dans notre quotidien ; pour le meilleur, peut être, et pour le pire, sûrement.

Officiellement, côté impact environnemental, le flou demeure pour 84% des usages de l’IA. Bien sûr, quelques entreprises ont communiqué sur cet impact. Google annonçait, cet été, qu’une requête “médiane” adressée à Gemini équivalait à 9 secondes de télévision. OpenAI, eux, se targuaient de 0,34 Wh la requête, l’équivalent d’1 seconde d’utilisation d’un four. Néanmoins, ces études sont intentionnellement sélectives et manquent de détails, comme le souligne un article de Bonpote. Pour OpenAI, c’est un flou artistique, sans méthode ni données… Un biais d’ancrage efficace en somme.

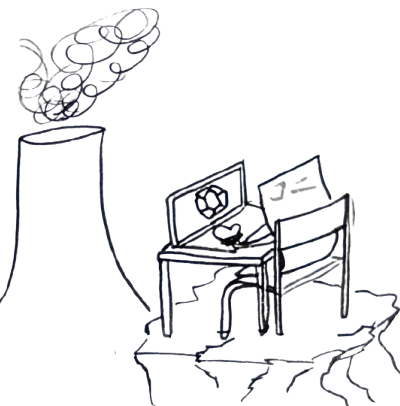

Ces beaux chiffres, sortis d’une communication savamment orchestrée, nous feraient presque oublier d’étudier l’impact global. En 2025, ChatGPT traitait 2,5 milliards de requêtes par jour. Ça fait long en temps de cuisson. La consommation à la requête nous éloigne de l’essentiel : l’impact global de ces entreprises. Quid de l’énergie utilisée, l’eau évaporée, le CO₂ rejeté ? Quel impact social et humain ?

Sur tous les rapports rédigés par les grandes entreprises, on observe une nouvelle tendance : promouvoir des IA “responsables”, et des data centers “neutres en carbone”. Mais derrière ces déclarations, la réalité est plus nuancée. Labels vagues, normes internationales quasi inexistantes, et déplacement des impacts vers d’autres pays rendent ces discours critiquables. Une nouvelle IA peut certes être plus performante, mais, si elle est hébergée dans une région à électricité bon marché, cela reste polluant.

Le paradoxe : plus les modèles sont performants, plus ils semblent “écologiques”. Une requête consommerait un peu moins d’énergie ? On se dit que son utilisation devient acceptable. Mais cette impression de progrès permet surtout de légitimer une explosion des usages. L’effet rebond est clair : c’est simple et accessible, alors on l’utilise, et la consommation énergétique globale augmente. L’INRAE l’a démontré : cette efficacité énergétique des modèles est suivie d’une hausse massive du nombre de requêtes, annulant les gains attendus.

Un rapport de Google l’illustre : son modèle Gemini a doublé sa consommation électrique en deux ans, au détriment de ses engagements de neutralité carbone. Avant même de l’utiliser, on relève que des millions de kWh sont nécessaires pour entraîner un modèle, des quantités massives d’eau pour refroidir les serveurs, et une dépendance de minerais rares comme le lithium ou le cobalt. Leur extraction a un coût social et environnemental fortement élevé.

Alors, peut-on vraiment se diriger vers une IA responsable ?

Sans régulation, transparence et sobriété numérique, l’IA “verte” reste surtout une belle illusion. Bien sûr, les entreprises et gouvernements ont un rôle important à jouer dans leur orchestration. Mais en tant qu’utilisateur, chacun a sa propre part de responsabilité : privilégier des modèles frugaux, open source, et surtout questionner l’utilité réelle de chaque usage. Car actuellement, éviter les modèles génératifs reste sans doute le geste le plus concret.